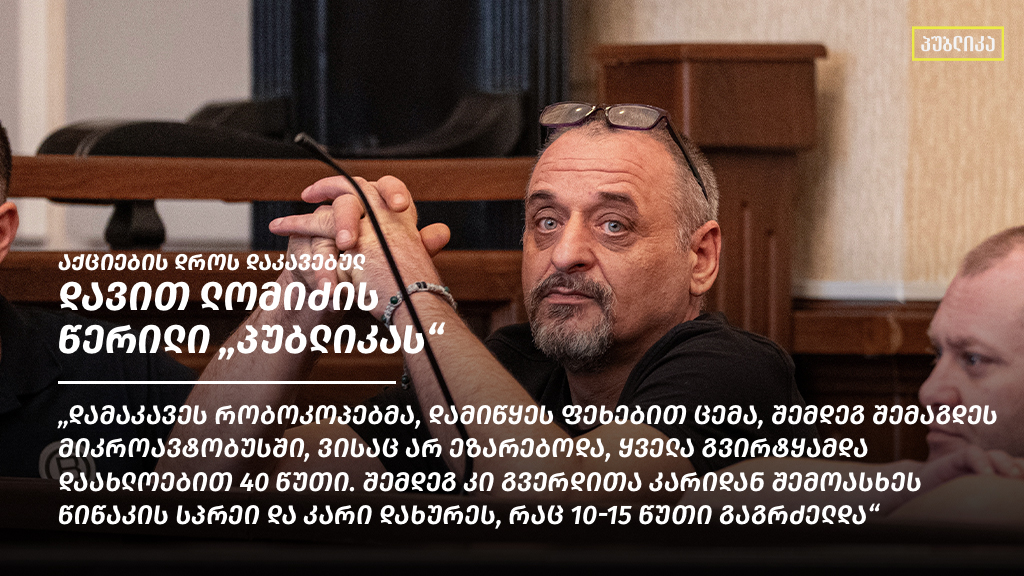

მარიამ გერსამია

შეიძლება თუ არა ალგორითმი გახდეს ეთიკური და მან სწორი გადაწყვეტილება მიიღოს? როგორ „ვასწავლოთ“ ხელოვნურ ინტელექტს ადამიანის უფლებები? რა საფრთხეები არის ე.წ. cookies უკან? რა იცვლება სოციალური ქსელების რეგულირების კუთხით და რა უნდა ვიცოდეთ, რომ ინტერნეტში ჩვენი უფლებები უფრო მეტად იყოს დაცული?

მედია და ტექნოლოგიები მოქმედებს ადამიანზე, ინდივიდებსა თუ ჯგუფებზე. ჩვენი უფლებების გააზრების კონტექსტში, მნიშვნელოვანია სამართლის კუთხით დანახული ტექნოლოგიების სამყარო. ადამიანის უფლებებზე და ტექნოლოგიების სამართალზე, ციფრულ სამყაროში მოსალოდნელ სამართლებრივ ცვლილებებზე ვსაუბრობთ სასექსის უნივერსიტეტის კურსდამთავრებულთან, ხელოვნური ინტელექტის და ინფორმაციული ტექნოლოგიების სამართლის მაგისტრთან მარიამ შარანგიასთან.

– ინტერნეტის თავისუფალი სივრცე დღეს ადამიანის განვითარების შესაძლებლობაა. ამ ბოლო დროს ბევრს საუბრობენ მოსალოდნელ რეგულაციებზე. რა მიდგომები და მეთოდები არსებობს რეგულირების კუთხით და რა ცვლილებებს უნდა ველოდოთ?

– ინტერნეტის რეგულირების თემა აქტუალობას არასდროს კარგავდა, თუმცა ეს საკითხი ბოლო წლების მანძილზე განსაკუთრებით მნიშვნელოვანი გახდა. შემოვიდა ახალი რეგულაციები, როგორიცაა ხელოვნური ინტელექტის რეგულირება და გადაისინჯა 1990-2000 წლის რეგულაციებიც, რომლებიც მანამდე ხელშეუხებელი იყო.

ზოგადად, ინტერნეტსივრცის რეგულირებასთან მიმართებით არსებობს სხვადასხვა მიდგომა. მათ შორისაა ძალიან ლიბერალური მიდგომა, რომ ინტერნეტი უნდა იყოს ბოლომდე თავისუფალი. ამ მიდგომის ერთ-ერთი გამოვლინებაა ამერიკელი მწერალის ჯონ პერი ბარლოუს ინტერნეტსივრცის თავისუფლების დეკლარაცია. მას სწორედ ამ მიდგომისთვის კიბერლიბერტარიანელ აქტივისტად მოიხსენიებდნენ. ის ამბობდა, რომ სახელმწიფოებს არ უნდა ჰქონდეთ იმის შესაძლებლობა, რომ ინტერნეტი დაარეგულირონ, რადგან აქ მათი ადგილი არ არის. შესაბამისად, ის იყო ინტერნეტის თავისუფლების მომხრე. ინტერნეტის თავისუფლების მოწინააღმდეგეები მსგავს მიდგომებს უტოპიურს უწოდებდნენ, არ ემხრობოდნენ და მიაჩნდათ, რომ ინტერნეტი არ იყო მხოლოდ დადებითი ფაქტორების მომტანი და შესაბამისად, ის საჭიროებდა რეგულირებას.

რაც შეეხება ინტერნეტის რეგულირების მეთოდებს, იგი იყოფა სამ ნაწილად. ესენია: თვითრეგულირება, თანარეგულირება და რეგულირება სახელმწიფოს მხრიდან. თვითრეგულირების მოდელში, ინტერნეტს არ არეგულირებს სახელმწიფო, ამის მაგალითია როდესაც თავად სოციალური ქსელი ქმნის წესებს და პირობებს იმ საკითხებთან მიმართებით, რომელიც რეგულირებული არ არის და ის თვითრეგულირებადი ხდება. თანარეგულირების შემთხვევაში მარეგულირებელი რეჟიმი შედგება ზოგადი კანონმდებლობისა და თვითრეგულირების ორგანოს კომპლექსური ურთიერთქმედებისგან, რეგულირების დროს კი ეს ბერკეტი სახელმწიფოს აქვს.

– გარკვეული უფლებების დაცვის საბაბით, ინტერნეტის რეგულაციამ ხომ შეიძლება გამოხატვის თავისუფლებასთან ან სხვა „უფლებებთან კონფლიქტი“ გამოიწვიოს?

– ადამიანის ძირითადი უფლებები მართლაც შესაძლოა კონფლიქტში მოდიოდეს მაშინ, როდესაც ჩვენ ინტერნეტსივრცეზე ვსაუბრობთ. ზოგჯერ თავად კანონიც ქმნის უფლებების კოლიზიას. მაგალითად, დირექტივა ციფრულ ბაზარზე საავტორო უფლებების შესახებ ისეთ სოციალური ქსელისთვის როგორიც YouTube-ია (სადაც კონტენტი ეხება საავტორო უფლებებს) აწესებს სანქციებს და შემოაქვს რიგი ვალდებულებებისა. ასეთია ლიცენზიის მოპოვება და ფილტრის სისტემის დანერგვა, რაც საკმაოდ რთული და ხარჯიანი პროცესია. უფლებების კონფლიქტი სწორედ იქ იწყება, როდესაც საავტორო უფლებების დაცვის მოტივით ხდება სხვა უფლებებში ჩარევა.

ზემოთ ნახსენები ფილტრის გამოყენებას, მომხმარებლის IP მისამართამდე და შესაბამისად, მის პირად მონაცემებამდე მივყავართ. გამოდის, რომ ერთი უფლების აღსრულებისას ირღვევა მეორე. ასევე მნიშვნელოვანია ითქვას, რომ რეგულირების აღსრულება გავლენას იქონიებს გამოხატვის თავისუფლებააზე. და ბოლოს, არ უნდა გამოგვრჩეს ბიზნესის გადმოსახედი, კანონის მოთხოვნის აღსრულება საკმაოდ მაღალბიუჯეტური პროცესია. შესაბამისად ფილტრის სისტემის დანერგვა საავტორო უფლებების დაცვის მოტივით იწვევს სამ სხვა უფლებასთან კოლიზიას. ესენია, ბიზნესის თავისუფლება (Freedom to Conduct a Business), გამოხატვის თავისუფლება (Freedom of Expression) და პირადი და ოჯახური ცხოვრების და პერსონალური მონაცემების დაცულობის უფლება (Data Protection, Privacy and Family Life).

– ფილტრის სისტემაში რა იგულისხმება? ეს ალგორითმია, რომელიც ამოწმებს და თავად იღებს გადაწყვეტილებას ინტერნეტში გამოვლენილი დარღვევის შესახებ?

– დიახ, ეს არის ფართო მონიტორინგი საავტორო უფლებების დაცვის მოტივით და სწორედ მისი მასშტაბურობა იწვევს პრობლემებს, რადგანაც სასამართლოს გადაწყვეტილებების მიხედვით, აკრძალულია გენერალური მონიტორინგი, იგი უნდა იყოს კონკრეტული მიზნით და დროში შემოფარგული. ფილტრის მოქმედების შემთხვევაში კი, სახეზეა მონიტორინგი, რომელიც არაა დროში შემოფარგლული და ეხება მრავალ მომხმარებელს განურჩევლად იმისა, არღვევენ ისინი საავტორო უფლებებს თუ არა. ადამიანთა განუსაზღვრელი რაოდენობის, განუსაზღვრელი დროით კონტროლი და მონიტორინგი საბოლოოდ უფლებებში ჩარევის საფრთხეს ზრდის.

– გარდა ისეთი სოციალური ქსელისა როგორიც არის Youtube-ი სხვა ტიპის სოციალურ ქსელთან მიმართებითაც, მაგალითად Facebook-ის შემთხვევაშიც, არსებობს ადამიანის უფლებების კონფლიქტი? და ასევე, რა სახის პრობელემი შეიძლება იქნეს გამოწვეული სოციალური ქსელების მხრიდან?

– მოგეხსენებათ, სოციალური ქსელი Facebook არაერთ სკანდალში გაეხვა. მაგალითად, ტრამპის საარჩევნო კამპანიისას, Facebook-ზე ინტეგრირებული ქვიზის მეშვეობით მოხდა პერსონალური მონაცემების შეგროვება რომელიც გამოყენებულ იქნა მოწყვლად ჯგუფების დასადგენად და შემდგომ, საარჩევნო ზეგავლენის მოსახდენად. ამის გამო Facebook-მა დიდი კრიტიკა და ფინანსური ჯარიმა მიიღო.

რაც შეეხება Youtube-სგან განსხვავებული სოციალური ქსელების შემთხვევაში არსებულ უფლებების კომფლიქტს, ამის ყველასთვის ცნობილი მაგალითია გასულ წელს კაპიტოლიუმის შენობაში მოქალაქეები შეჭრისას, ტრამპის ანგარიშების მიმართ Twitter-ისა და Facebook-ის ქმედება, როდესაც მის გვერდს განუსაზღვრელი ვადით შეუჩერეს მოქმედება. ეს მოქმედება მათი მხრიდან ახსნილ იყო, როგორც ძალადობის შემდგომი წაქეზების რისკის პრევენცია. თუმცა, რა თქმა უნდა ამან გამოიწვია აზრთა სხვადასხვაობა იმაზე, იყო თუ არა ეს გამოხატვის თავისუფლების შეზღუდვა.

– რა ხდება მაშინ, როდესაც ინტერნეტში ავტომატურად ვეთანხმებით გარკვეულ წესებს ან შემოთავაზებებს, გაუცნობიერებლად თავად ვაძლევთ გარკვეული უფლებების დარღვევის საშუალებას ამა თუ იმ კომპანიას?

ადამიანებს ზოგადად აქვთ წარმოდგენა, რომ მათ შესახებ ხდება ინფორმაციის შეგროვება, თუმცა ვერ ხედავენ იმ ფაქტს, რომ მათი პერსონალური ინფორმაციის გარდა ისინი აზიარებენ ქცევით ინფორმაციასაც, რითიც ხდება განჭვრეტადი/მოსალოდნელი ქცევის ინფორმაციის შეგროვებაც. როდესაც ვებ-გვერდებზე შევდივართ გაუცნობიერებლად ვეთანხმებით „მზა ჩანაწერებს“ ანუ cookies პოლიტიკას, თუმცა ნაკლებად ვიცით, თუ რა დგას მის უკან. რეალურად, პოლიტიკის დოკუმენტში ახსნილია თუ რა მიზნით მოხდება ინფორმაციის გამოყენება და ჩვენ დასტურით გამოვხატავთ თანხმობას. თავდაპირველად cookies უფრო მარტივ და რეკლამაზე მორგებულ მიზნებში გამოიყენებოდა. თუმცა, შემდეგ უფრო ფართომაშტაბიანი გახდა და შესაბამისად, მეტი გავლენა აქვს ადამიანებზე. როდესაც თქვენ ეთანხმებით cookies პირობებს, თქვენი მონაცემები გარდა იმ კონკრეტული ვებ-გვერდისა, შესაძლოა გაზიარებულ იქნეს მესამე პირებზე და Real-time bidding-ის გამოყენებით ანუ „რეალურ დროში აუქციონზე” გატანის გზით გადაეცეს სხვადასხვა კომპანიას და შემდეგ, თქვენს მიერ ინტერნეტში გამოხატულ ქცევის წესთან მაქსიმალურად მიახლოებული შემოთავაზებები დაგიბრუნდეთ.

– ინტერნეტში ყოფნა ავტომატურად ნიშნავს კომერციული კომპანიებისთვის პროდუქტად ყოფნას თუ შეგვიძლია პერსონალური მონაცემების კანონით ამის კონტროლი?

– პერსონალურ მონაცემთა დაცვის ზოგადი რეგულაცია (General Data Protection Regulation (GDPR)) არა ერთ გარანტიას გვთავაზობს ჩვენი პერსონალური მონაცემების დამუშავების კუთხით. ერთი შეხედვით ეს კანონი გვიცავს, რომ სურვილის შემთხვევაში, უარი ვთქვათ პერსონალური მონაცემების გაზიარებაზე, ვაკონტროლოთ თუ სად და როგორ ხდება ჩვენი მონაცემების გაზიარება. თუმცა, ხელოვნური ინტელექტის არქიტექტურის სიღრმისეული შესწავლისას მარტივად ვლინდება, რომ ალგორითმებთან მიმართებით არც თუ ისე მბოჭავია კანონი, როგორიც ეს ერთი შეხედვით ჩანს. შესაბამისად, თუ კი ჩვენი უფლებები რეალიზებული ვერ იქნება -შედეგები ჩვენს კონტროლს მიღმა რჩება.

მაგალითად, შეგვიძლია განვიხილოთ სამი თითქოსდა ყველაზე ეფექტური უფლება და მათი რეალური დაცვის ფარგლები ხელოვნურ ინტლექტთან მიმართებით. ერთ-ერთი მათგანია ე.წ. ახსნის უფლება (right to explanation), ეს უფლება მისი დასახელებიდან გამომდიარე უკვე გვეუბნება, რომ საუბარია დასრულებულ პროცესზე, რომლის ახსნა-განმარტების მოთხოვნის უფლებასაც კანონი გვაიჭებს, შესაბამისად, ის ვერასდროს იქნება გარანტია იმ ეკონომიკური თუ ემოციური ზიანის, რაც შეიძლება ადამიანს მიადგეს. ამავდროულად, ახსნის უფლების გმაოყენებისას ჩვენ ვითხოვთ იმის ახსნას, თუ როგორ მუშაობს ალგორითმი, რამაც შესაძლოა უფრო მეტი პერსონალური მონაცემების გამოაშკრავებამდე მიგვიყვანოს და საზიანო ეფექტი ჰქონდეს. შესაბამისად ცხადია რომ „შავი ყუთის“ გახსნა ამ უფლების გამოყენებით არ აღმოფხვრის პრობლემებს.

მსგავსაც განხილული უფლებისა, ალგორითმებთან მიმართებით ნაკლებად ფუნქციურია წვდომის უფლებაც (Right of access by the data subject) – წვდომა მნიშვნელოვანი ინფორმაციის ლოგიკის შესახებ. რადგან პირველ რიგში წვდომის უფლებით ვითხოვთ ისევ და ისევ ალგორითმის ლოგიკაზე წვდომას, რითიც ვიჭრებით კომპანიის კომერციულ საიდუმლოებაში, რაც ცალკე დაცვის სფეროა. ამავდროულად, ხელოვნური ინტელექტის არქიტექტურიდან გამომდინარე, წვდომა იმდენად ხარჯიანი პროცესია, რომ ბალანსი პერსონალურ მონაცემთა დაცვასა და ბიზნესის უფლებას შორის დარღვეული იქნება, რადგან მიზნის მიღწევის პროპორციულ მექანიზმად ვერ იქნება შეფასებული.

ერთ-ერთი ყველაზე მორგებული უფლება ალგორითმებთან მიმართებით, რომელიც გულისხმობს დასაწყისშივე ადამიანის პერსონალური მონაცემების დაცვას არის პერსონალური მონაცემების უფლებების გარანტირება დიზაინის შექმნის ეტაპზე (Data protection by design and by default), რომელიც მოიაზრებს ფსევდონიმიზაციის უფლებას. ერთი შეხედვით ამ უფლებას მაღალი დაცვის სტანდარტი აქვს, თუმცა მსგავსად სხვა უფლებებისა, რეალობა ალგორითმებთან მიმართებით განსხვავებულია. იგი წინააღმდეგობაში მოდის ამავე კანონით გარანტირებულ სხვა უფლებებთან, რადგან ფსევდონიმიზაციის შემდგომ, გართულდება წვდომის და წაშლის უფლებების აღსრულება.

მოკლედ, თქვენი კითხვის პასუხად, თუ რამდენად გვაქვს კონტროლი, შეგვიძლია ვთქვათ, რომ კანონი თითქოს გვანიჭებს კონტროლის არა ერთ მექანიზმს, რომელიც რა თქმა უნდა ხელს უწყობს პრობლემის მინიმიზაციას, თუმცა პერსონალურ მონაცემთა დაცვის შესახებ კანონი მორგებულია ინდივიდებზე. როდესაც ვსაუბრობთ ხელოვნურ ინტელექტზე და ალგორითმებზე, საუბარია უფრო მეტად ჯგუფურ უფლებებზე ვიდრე ინდივიდუალურზე, შესაბამისად ისინი ვერ იძლევიან სრულ დაცვას.

– ტექნოლოგიურმა პროგრესმა აჩვენა, რომ ალგორითმი თუ ხელოვნური ინტელექტი გადაწყვეტილებების მიღებას მაქსიმალური სიზუსტით ცდილობს, რა საფრთხეებია და რამდენად სანდოა ალგორითმი, როდესაც საქმე ეხება ადამიანის უფლებებს?

– რაც შეეხება ადამიანის უფლებებს და ხელოვნური ინტელექტის სანდოობას, აქ არა ერთი გამოწვევის წინაშე ვდგავართ. ხელოვნური ინტელექტის შესაძლებლობებმა ჩაანაცვლა სხვადასხვა პროცესი, იგი გამოიყენება უნივერსიტეტის მიღების ეტაპზე თუ სამსახურში გასაუბრებისას. ჩინეთში სოციალური დახარისხების მიზნით აგროვებენ პირად ინფორმაციას, მიღებული ინფორმაცია კი სამომავლოდ განაპირობებს ადამიანების დაშვებას სხვადასხვა შესაძლებლობებზე. უფრო მეტიც, იყო შემთხვევები, როდესაც ხელოვნური ინტელექტი გამოიყენეს ადამიანის სექსუალური ორიენტაციის დასადგენად სოციალურ ქსელში მისი მეგობრების სიაზე დაფუძნებით. ამავდროულად სასამართლო სისტემაშიც ხდება ხელოვნური ინტელექტის ჩართვა. პრაქტიკამ კი აჩვენა, რომ გადაწყვეტილებების მიღებისას ალგორითმი ბევრ არასასურველ შედეგს დებს და არის დისკრიმინაციის შემთხვევები. ეს კი ბადებს ახალ გამოწვევებს, ხელოვნური ინტელექტის დახვეწის კუთხით. ეს ყველაფერი აჩვენებს, რომ რა თქმა უნდა, არის ხელოვნური ინტელექტის გამოყენების არაეთიკური მიდგომები.

ახალი კანონების მიხედვით, ადამიანის უფლებები ისე უნდა იყოს დაცული ონლაინ სივრცეში, როგორც რეალურ ცხოვრებაში. რაც შეეხება ხელოვნური ინტელექტისთვის ადამიანის უფლებების „სწავლებას“, ესეც არის დიდი დილემა, როგორც სამართლებრივად, ასევე ტექნიკურად. მიდის მსჯელობა იმასთან დაკავშირებთ თუ როგორ უნდა გავხადოთ ალგორითმი მეტად ეთიკური. ამ კუთხით საუბრობენ სამართლიანობის, გამჭვირვალობის და ანგარიშვალდებულების პრინციპების დანერგვაზე ხელოვნურ ინტელექტში. ერთი შეხედვით მარტივია დააინტეგრირო თანასწორობის პრინციპი ხელოვნურ ინტელექტში და მიიღო არადისკრიმინირებული შედეგი, მაგრამ პრაქტიკაში ეს უფრო რთულია, რადგან თითოეული ამ პრინციპის ინტერვენცია უნდა განხორციელდეს ხელოვნური ინტელექტის ფუნქციონირების ყველა ეტაპზე. მაგალითად სამართლიანობის ინტეგრირება მხოლოდ დასაწყის ეტაპზე, არასაკმარისია, ის უნდა განხორციელდეს პროცესის დაწყებისას, როდესაც ვკვებავთ მონაცემებით (data fairness) პროცესის მიმდინარეობისას (design fairness) და პროცესის დასრულებისას (outcome fairness).

– შეგვიძლია თუ არა ვუჩივლოთ კომპანიას ხელოვნური ინტელექტის მიერ გამოტანილი „განაჩენის“ გამო?

– დიახ, ეს გათვალისწინებულია პერსონალურ მონაცემთა დაცვის კანონში. იკრძალება მხოლოდ ალგორითმის მიერ ავტომატურად მიღებული გადაწყვეტილების აღსრულება. ამის მაგალითია დავა Uber-თან. როდესაც მომხმარებელი Uber-ის აპლიკაციის გამოყენებისას დაბალ შეფასებას უწერს ტაქსის მძღოლს, ალგორითმის მიერ მიღებული გადაწყვეტილებით მძღოლს შეიძლება ჩამოერთვას ლიცენზია, ხოლო კანონი პირდაპირ ამბობს, რომ იკრძალება ავტომატური გადაწყვეტილება რომელიც ინდივიდზე მნიშვნელოვანი გავლენის მქონე შეიძლება იყოს.

– ახალი წესებისა და მიდგომების მიხედვით, რა უნდა იცოდეს სოციალური ქსელის მომხმარებელმა, იმისთვის რომ იყოს უფრო დაცული?

– რაც შეეხება ახალ რეგულაციებს, კონტენტის მოდერაციის საკითხში ახალი წესები და ვალდებულებებია შემოღებული, ეს რეგულაციები ამკაცრებს მოთხოვნებს და სთხოვს სოციალურ მედიებს, რომ ჰქონდეთ უფრო მეტად გამჭვირვალე პროცესი. ისინი ვალდებულნი იქნებიან ახსნან ალგორითმის მოქმედების პრინციპები და გადაწყვეტილებები, რომლებსაც ალგორითმი იღებს. პლატფორმებს, რომლებიც კონტენტს ათავსებენ საკუთარ სივრცეში, ექმნებათ ვალდებულება, რომ ინდივიდებს მისცენ უფრო მეტი ინფორმაცია, ვიდრე აქამდე. ანუ, ჩვენ უფრო დეტალურად მივიღებთ ინფორმაციას იმაზე, თუ რატომ წაიშალა პოსტი. Facebook-ს მოუწევს ყოველწლიური ანგარიშის წარდეგნა შემოსული და დამუშავებული მოთხოვნების შესახებ. გარდა ამისა, ინტერვენციის პროცესში გამოჩნდება უფრო მეტი პირი, მათ შორის მეტი იქნება აკადემიური სფეროს წარმომადგენლების ჩართულობა.

პოდკასტი „მედიახმა“ ხორციელდება მედიის და კომუნიკაციის საგანმანათლებლო და კვლევითი ცენტრის მიერ, საქართველოს უნივერსიტეტისა და ონლაინ გამოცემა „პუბლიკას“ მხარდაჭერით. პოდკასტის ავტორია მარიამ გერსამია.